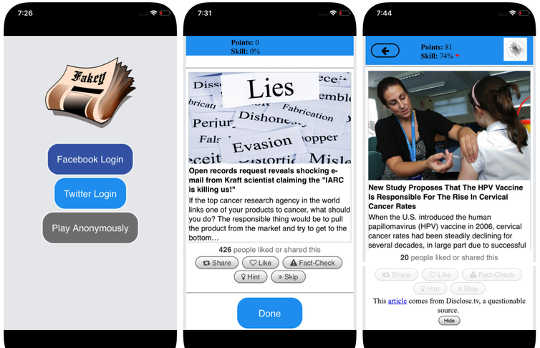

Screenshots van die Fakey spel. Mihai Avram en Filippo Menczer

Screenshots van die Fakey spel. Mihai Avram en Filippo Menczer

Sosiale media is een van die primêre bronne van nuus in die VSA en regoor die wêreld. Tog word gebruikers blootgestel aan inhoud van twyfelagtige akkuraatheid, insluitend sameswerings teorieë, clickbait, hiperpartisiese inhoud, pseudo-wetenskap en selfs vervaardigde "vals nuus" verslae.

Dit is nie verbasend dat daar soveel disinformasie gepubliseer is nie: Spam en aanlynbedrog is winsgewend vir misdadigers, en regering en politieke propaganda opbrengs beide partydige en finansiële voordele. Maar die feit dat Lae geloofwaardigheid inhoud versprei so vinnig en maklik stel voor dat mense en die algoritmes agter sosiale media-platforms kwesbaar vir manipulasie is.

Ons navorsing het drie tipes vooroordeel geïdentifiseer wat die sosiale media-ekosisteem kwesbaar maak vir beide opsetlike en toevallige verkeerde inligting. Daarom is ons Observatory on Social Media by Indiana Universiteit is gebou gereedskap om mense te help om hierdie vooroordeel bewus te maak en hulself te beskerm teen buite-invloede wat ontwerp is om hulle te ontgin.

Verduidelik die gereedskap wat by die Observatorium op Sosiale Media ontwikkel is:

{youtube}https://youtu.be/BIv9054dBBI{/youtube}

Bias in die brein

Kognitiewe vooroordeel kom uit die manier waarop die brein die inligting verwerk wat elke persoon elke dag ontmoet. Die brein kan slegs 'n beperkte hoeveelheid inligting hanteer, en te veel inkomende stimuli kan veroorsaak information overload. Dit op sigself het ernstige implikasies vir die gehalte van inligting oor sosiale media. Ons het gevind dat steil mededinging vir gebruikers se beperkte aandag dit beteken 'n paar idees gaan virale ten spyte van hul lae gehalte - selfs wanneer mense verkies om inhoud van hoë gehalte te deel.

Om te voorkom dat dit oorweldig word, gebruik die brein 'n aantal truuks. Hierdie metodes is gewoonlik effektief, maar kan ook word vooroordeel wanneer dit in die verkeerde kontekste toegepas word.

Een kognitiewe kortpad gebeur wanneer 'n persoon besluit of 'n storie wat op hul sosiale media-voer verskyn, moet deel. Mense is baie geraak deur die emosionele konnotasies van 'n kop, alhoewel dit nie 'n goeie aanduiding is van die akkuraatheid van 'n artikel nie. Baie belangriker is wie het die stuk geskryf.

Om hierdie vooroordeel teen te werk en mense te help om meer aandag te skenk aan die bron van 'n eis voordat dit gedeel word, het ons ontwikkel Fakey, 'n mobiele nuus geletterdheid spel (gratis op Android en IOS) simuleer 'n tipiese sosiale media nuus voer, met 'n mengsel van nuus artikels van hoofstroom en lae geloofwaardigheid bronne. Spelers kry meer punte om nuus uit betroubare bronne te deel en verdagte inhoud vir feitekontrole te merk. In die proses leer hulle om seine van geloofwaardigheid van die bron te herken, soos hipartpartiese eise en emosionele gelaaide opskrifte.

Bies in die samelewing

Nog 'n bron van vooroordeel kom van die samelewing. Wanneer mense direk met hul eweknieë koppel, kom die sosiale vooroordeel wat hul keuse van vriende lei, om die inligting wat hulle sien, te beïnvloed.

Trouens, in ons navorsing het ons gevind dat dit moontlik is om bepaal die politieke leunings van 'n Twitter-gebruiker deur eenvoudig na die partydige voorkeure van hul vriende te kyk. Ons ontleding van die struktuur van hierdie partydige kommunikasienetwerke Gevorderde sosiale netwerke is besonder doeltreffend om inligting te versprei - akkuraat of nie - wanneer hulle is nou vasgebind en afgesluit van ander dele van die samelewing.

Die neiging om inligting gunstiger te evalueer as dit uit hul eie sosiale kringe kom, skep "eggo kamers"Dit is ryp vir manipulasie, hetsy bewustelik of onophoudelik. Dit help om te verduidelik hoekom so baie aanlyngesprekke aangaan "Ons teenoor hulle" konfrontasies.

Om te bestudeer hoe die struktuur van aanlyn sosiale netwerke gebruikers kwesbaar maak vir disinformasie, het ons gebou Hoaxy, 'n stelsel wat die verspreiding van inhoud van lae geloofwaardigheidsbronne naspeur en visualiseer, en hoe dit kompeteer met feitekontrole-inhoud. Ons analise van die data wat deur Hoaxy versamel is tydens die presidensiële verkiesings van 2016, toon dat Twitter-rekeninge wat verkeerde inligting gedeel het, was amper heeltemal afgesny uit die regstellings wat deur die feitekontroleurs gemaak is.

Toe ons op die verkeerde inligtingverspreidingsrekeninge geboor het, het ons 'n baie digte kerngroep rekeninge gevind wat byna uitsluitlik mekaar reggekry het - insluitend verskeie botsings. Die enigste keer dat faktuurkontrole-organisasies ooit deur die gebruikers in die misinformeerde groep aangehaal of genoem is, was wanneer hulle hul legitimiteit bevraagteken of die teenoorgestelde van hul skryfwerk aanspraak maak.

Bies in die masjien

Die derde groep vooroordeel ontstaan direk uit die algoritmes wat gebruik word om te bepaal wat mense aanlyn sien. Beide sosiale media platforms en soekenjins gebruik hulle. Hierdie personaliseringstegnologieë is ontwerp om slegs die mees innemende en toepaslike inhoud vir elke individuele gebruiker te kies. Maar dit kan uiteindelik die kognitiewe en sosiale vooroordeel van gebruikers versterk, waardeur hulle selfs meer kwesbaar vir manipulasie word.

Byvoorbeeld, die gedetailleerde advertensie gereedskap gebou in baie sosiale media platforms laat disinformation veldtogte ontgin bevestiging vooroordeel by aanpas van boodskappe aan mense wat reeds geneig is om hulle te glo.

Ook, as 'n gebruiker dikwels op Facebook-skakels van 'n bepaalde nuusbron klik, sal Facebook dit doen is geneig om daardie persoon meer van die webwerf se inhoud te wys. Hierdie sogenaamde "filter borrel"-Effek kan mense van uiteenlopende perspektiewe isoleer, versterking van vooroordeel-vooroordeel.

Ons eie navorsing toon dat sosiale media-platforms gebruikers blootstel aan 'n minder uiteenlopende stel bronne as wat nie-sosiale media-webwerwe soos Wikipedia is. Omdat dit op die vlak van 'n hele platform is, nie van 'n enkele gebruiker nie, noem ons dit die homogeniteit vooroordeel.

Nog 'n belangrike bestanddeel van sosiale media is inligting wat op die platform neig, volgens wat die meeste druk kry. Ons noem dit gewildheid vooroordeel, omdat ons gevind het dat 'n algoritme wat ontwerp is om populêre inhoud te bevorder, die algehele gehalte van inligting op die platform kan beïnvloed. Dit lei ook tot bestaande kognitiewe vooroordeel, wat versterk wat blykbaar gewild is, ongeag die kwaliteit daarvan.

Al hierdie algoritmiese vooroordele kan gemanipuleer word deur sosiale botsings, rekenaarprogramme wat met mense kommunikeer deur middel van sosiale media-rekeninge. Die meeste sosiale bots, soos Twitter's Big Ben, is onskadelik. Sommige verberg egter hul regte aard en word gebruik vir kwaadwillige bedoelings, soos bevordering van disinformasie of vals die verskyning van 'n voetsoolvlakbeweging skep, ook bekend as "astroturfing." Ons het gevind bewyse van hierdie tipe manipulasie in die aanloop tot die 2010 Amerikaanse midterm verkiesing.

Om hierdie manipulasiestrategieë te bestudeer, het ons 'n instrument ontwikkel om sosiale bots op te spoor Botometer. Botometer gebruik masjien om botrekeninge op te spoor deur duisende verskillende kenmerke van Twitter-rekeninge te inspekteer, soos die tye van sy poste, hoe dikwels dit tweet, en die rekeninge wat volg en retweets. Dit is nie perfek nie, maar dit het aan die lig gebring dat soveel as 15 persent van Twitter-rekeninge toon tekens van botsings.

Met behulp van Botometer in samewerking met Hoaxy het ons die kern van die misinformatienetwerk tydens die 2016 Amerikaanse presidensiële veldtog ontleed. Ons het baie bots gevind wat beide die kognitiewe, bevestigings- en gewildheidsvooroordeel van hul slagoffers en Twitter se algoritmiese vooroordeel ontgin.

Hierdie bots is in staat om filterborrels rondom kwesbare gebruikers te konstrueer, hulle vals eise en verkeerde inligting te verskaf. Eerstens kan hulle die aandag van menslike gebruikers aantrek wat 'n bepaalde kandidaat ondersteun deur die kandidaat se hashtags te tweeting of deur die persoon te noem en te retweet. Dan kan die botse vals eise versterk wat teenstanders versmelt deur artikels uit lae geloofwaardigheidsbronne wat ooreenstem met sekere sleutelwoorde, weer te gee. Hierdie aktiwiteit maak ook die algoritme bekend vir ander gebruikers vals stories wat wyd gedeel word.

Verstaan komplekse kwesbaarhede

Selfs as ons navorsing en ander se wys hoe individue, instellings en selfs hele samelewings op sosiale media gemanipuleer kan word, is daar baie vrae links om te antwoord. Dit is veral belangrik om te ontdek hoe hierdie verskillende vooroordeel interaksie met mekaar het, wat moontlik meer komplekse kwesbaarhede kan skep.

Bykomstighede soos ons bied internetgebruikers meer inligting oor disinformation, en daarom 'n mate van beskerming teen sy slegte dinge. Die oplossings sal Dit sal waarskynlik nie tegnologies wees nie, alhoewel daar waarskynlik tegniese aspekte vir hulle sal wees. Maar hulle moet in ag neem die kognitiewe en sosiale aspekte van die probleem.

Oor die skrywers

Giovanni Luca Ciampaglia, Assistent Navorsingswetenskaplike, Instituut vir Instituut vir Instituut vir Instituut in Indiana, Indiana University en Filippo Menczer, professor in Rekenaarwetenskap en Informatika; Direkteur van die Sentrum vir Komplekse Netwerke en Stelselnavorsing, Indiana University

Hierdie artikel is oorspronklik gepubliseer op Die gesprek. Lees die oorspronklike artikel.

verwante Boeke

at

Dankie vir die besoek InnerSelf.com, waar daar is 20,000 + lewensveranderende artikels wat "Nuwe houdings en nuwe moontlikhede" bevorder. Alle artikels word vertaal in 30+ tale. Teken In aan InnerSelf Magazine, wat weekliks gepubliseer word, en Marie T Russell se Daily Inspiration. InnerSelf Magazine is sedert 1985 gepubliseer.

Dankie vir die besoek InnerSelf.com, waar daar is 20,000 + lewensveranderende artikels wat "Nuwe houdings en nuwe moontlikhede" bevorder. Alle artikels word vertaal in 30+ tale. Teken In aan InnerSelf Magazine, wat weekliks gepubliseer word, en Marie T Russell se Daily Inspiration. InnerSelf Magazine is sedert 1985 gepubliseer.